Fichiers robots.txt et sitemap.xml : configuration optimale

Avez-vous déjà passé des heures à optimiser le SEO de votre site, pour finalement réaliser qu’une simple configuration de fichiers pouvait faire toute la différence ? C’est un peu comme préparer un plat délicieux, mais oublier un ingrédient essentiel. Dans le monde du SEO technique, les fichiers robots.txt et sitemap.xml jouent des rôles cruciaux que beaucoup de développeurs et spécialistes du SEO négligent. Dans cet article, nous allons examiner pourquoi ces fichiers sont si importants, comment les configurer correctement, et quand il peut être judicieux de faire appel à un professionnel pour éviter des erreurs coûteuses.

Comprendre les enjeux des fichiers robots.txt et sitemap.xml

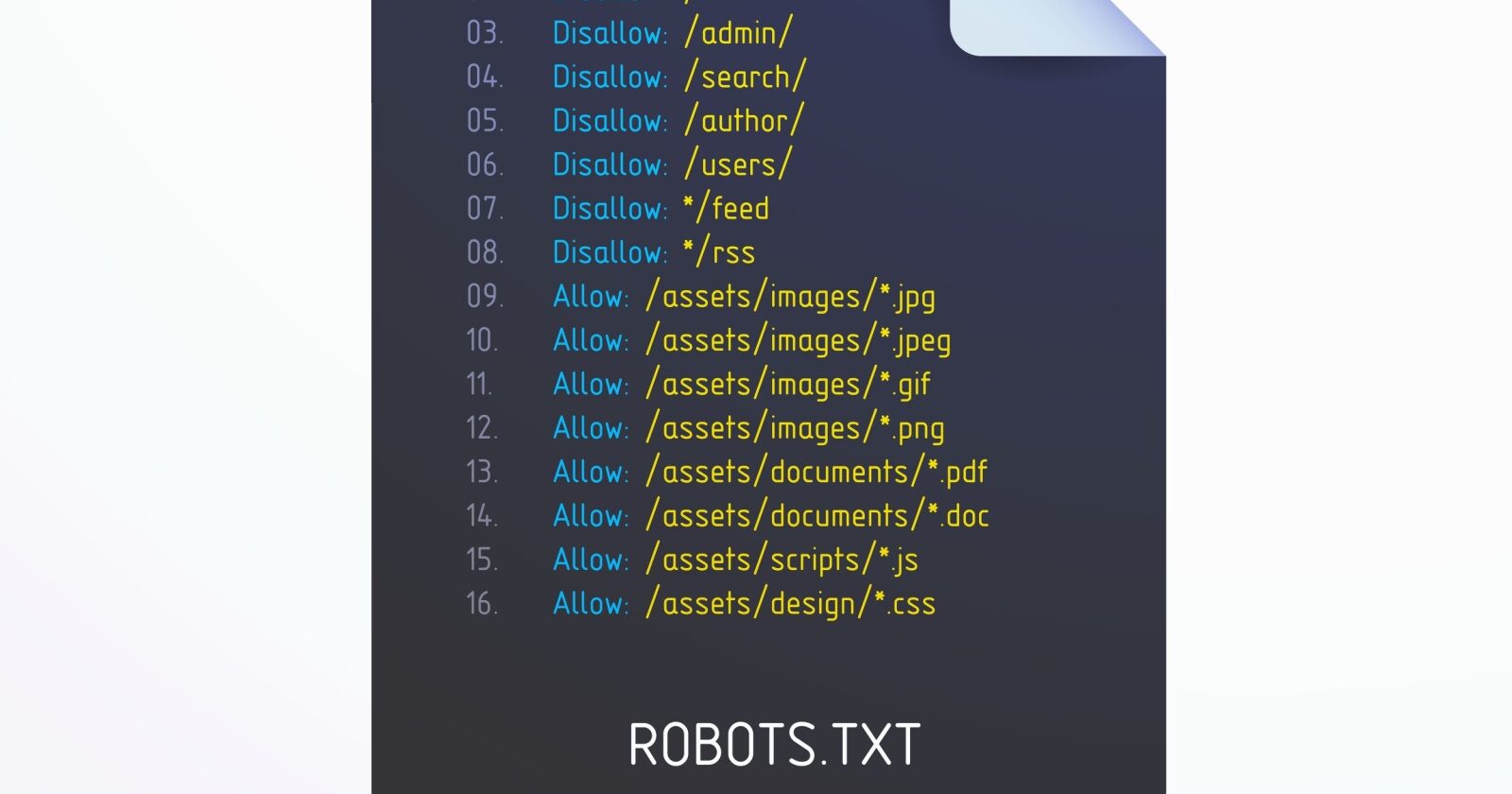

Pour commencer, il est essentiel de comprendre ce que sont ces fichiers et pourquoi ils sont si importants pour le SEO technique. Le fichier robots.txt est un document que vous placez à la racine de votre site pour indiquer aux moteurs de recherche quelles pages ils peuvent ou ne peuvent pas explorer. Imaginez-le comme un gardien d’entrée qui vous dit quelles portes sont ouvertes ou fermées. À l’inverse, le fichier sitemap.xml est une sorte de plan de votre site que vous soumettez aux moteurs de recherche, leur indiquant où trouver chaque page. C’est donc un peu comme une carte au trésor, leur facilitant la tâche pour explorer votre contenu.

Les problèmes surviennent souvent lorsque ces fichiers ne sont pas configurés correctement. Par exemple, si votre robots.txt bloque l’accès à des pages importantes, vous risquez de perdre du trafic et de diminuer votre visibilité sur les moteurs de recherche. À l’inverse, un sitemap.xml mal structuré peut rendre votre contenu difficile à trouver. Avez-vous déjà été confronté à des pages qui ne sont pas indexées comme prévu ? C’est peut-être dû à une configuration inappropriée de ces fichiers. Surveillez donc les signes : des baisses de trafic, des erreurs d’exploration dans Google Search Console, ou encore des pages non indexées.

Optimiser vos fichiers pour un SEO efficace

Pour éviter les tracas liés à une mauvaise configuration, voici quelques conseils pour optimiser vos fichiers robots.txt et sitemap.xml. Tout d’abord, assurez-vous que votre robots.txt n’empêche pas l’exploration de pages cruciales. Une bonne pratique consiste à inclure des directives claires pour les moteurs de recherche. Par exemple, si vous avez un répertoire d’administration que vous souhaitez cacher, indiquez-le clairement, mais veillez à ne pas bloquer des ressources essentielles comme des fichiers CSS ou JavaScript qui peuvent impacter le rendu de vos pages.

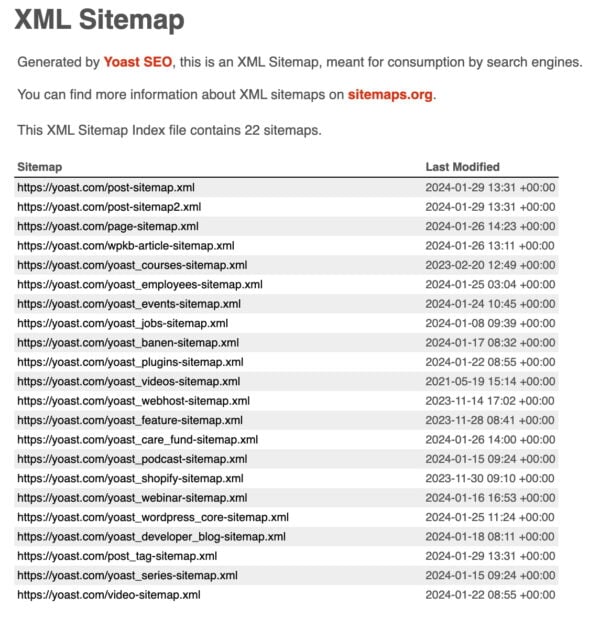

Concernant le sitemap.xml, il est vital qu’il soit à jour et qu’il reflète fidèlement la structure de votre site. Chaque page doit y figurer, accompagnée de métadonnées pertinentes, comme la date de dernière modification et la fréquence de mise à jour. Utilisez des outils comme Google Search Console pour soumettre votre sitemap et surveiller son efficacité. Une erreur courante à éviter est de soumettre un sitemap rempli de liens morts ou de pages en erreur, ce qui pourrait nuire à votre classement. Pensez également à vérifier régulièrement les erreurs d’exploration pour ajuster rapidement votre configuration.

Quand faire appel à un expert en SEO ?

Il arrive parfois que malgré tous vos efforts, les résultats ne soient pas au rendez-vous. C’est là que l’intervention d’un professionnel peut s’avérer bénéfique. Si vous constatez des baisses de trafic inexplicables, des erreurs d’exploration fréquentes ou si vous n’êtes pas à l’aise avec les aspects techniques de la configuration de vos fichiers, n’hésitez pas à consulter un expert. L’un des signes d’alerte pourrait être une stagnation dans l’évolution de votre site, alors que vous avez mis en place de nombreuses optimisations.

Faire appel à un professionnel peut vous apporter un regard neuf et une expertise spécifique pour diagnostiquer des problèmes que vous auriez pu manquer. Avant de le contacter, préparez-vous en rassemblant des données sur votre trafic, les erreurs d’exploration rencontrées, et les modifications que vous avez déjà entreprises. Cela permettra à l’expert de comprendre rapidement votre situation et de vous orienter vers des solutions adaptées.

Conclusion

En somme, la configuration optimale de vos fichiers robots.txt et sitemap.xml est essentielle pour garantir une bonne visibilité et une navigation fluide sur votre site. Ces outils peuvent sembler simples, mais leur impact sur votre SEO technique est indéniable. N’hésitez pas à les vérifier régulièrement et à les optimiser pour éviter des erreurs qui pourraient nuire à votre performance en ligne. Si vous avez des doutes, n’hésitez pas à faire appel à un professionnel pour vous accompagner. Alors, prêt à plonger dans l’optimisation de votre site ?